Valeo.ai

Nous développons, au cœur de Paris, un centre de recherche consacré à l’intelligence artificielle pour applications automobiles afin d’y conduire des projets de recherche ambitieux, notamment dans les domaines de la conduite assistée et des véhicules autonomes.

L’intelligence artificielle est déjà au cœur de la transformation du véhicule automobile ! Il y a 10 ans, il n’y avait pas de véritable IA dans les voitures. Aujourd’hui, la plupart d’entre elles sont équipées de logiciels, dont une partie est liée à l’IA. L’intelligence artificielle est en train de changer la mobilité dans le monde entier !

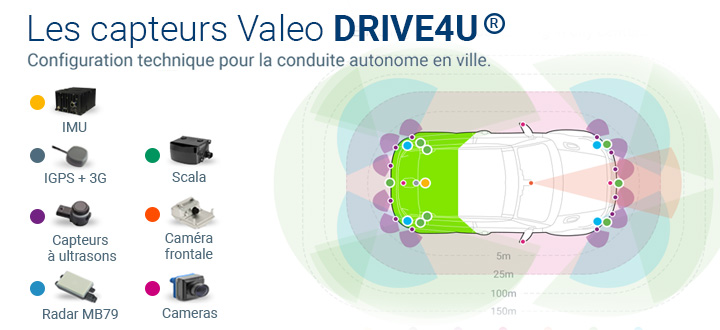

Perception multi-capteurs

La conduite automatisée repose en premier lieu sur différents capteurs, comme des caméras, des LiDARs, des radars et des capteurs à ultrasons Valeo. Exploiter au mieux les informations transmises à chaque instant par chacun de ces capteurs est essentiel pour appréhender l’environnement complexe du véhicule. C’est pourquoi nous explorons différentes approches d’apprentissage profond (deep learning) qui prennent en compte les capteurs isolément et collectivement.

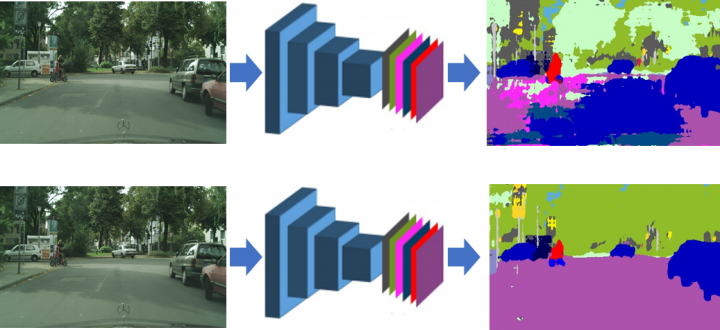

Adaptation de domaine

L’apprentissage profond et l’apprentissage par renforcement sont des technologies clés pour la conduite autonome. L’un des défis auxquels elles sont confrontées est de s’adapter à des conditions différentes de celles vues à l’entraînement. Pour améliorer les performances des systèmes dans de telles situations, nous explorons des techniques dites d’« adaptation de domaine », comme dans AdvEnt, notre projet présenté à CVPR 2019.

Estimation d’incertitude

En cas d’imprévu, lorsque le temps se dégrade ou lorsqu’un capteur n’est plus opérationnel, le système de perception embarqué doit diagnostiquer la situation et réagir de manière adéquate, en recourant, par exemple, à un système alternatif ou en avertissant le conducteur humain. Dans cette optique, nous étudions des moyens automatiques d’évaluer l’incertitude d’un système et de prédire sa performance.

Rencontrez notre équipe

-

Doctorant Florent Bartoccioni

Doctorant Florent Bartoccioni

Doctorant

Perception | Scene understanding | Dynamic forecasting

ENS Rennes | CTU Prague | INRIA

-

Chercheur Alexandre Boulch

Chercheur Alexandre Boulch -

Chercheur Andrei Bursuc

Chercheur Andrei Bursuc -

Chercheur Mickaël Chen

Chercheur Mickaël Chen -

Directeur de recherche Matthieu Cord

Directeur de recherche Matthieu Cord -

Chercheur Spyros Gidaris

Chercheur Spyros Gidaris -

Chercheur David Hurych

Chercheur David Hurych -

Directeur de recherche Renaud Marlet

Directeur de recherche Renaud Marlet -

Chercheur Gilles Puy

Chercheur Gilles Puy -

Chercheur Oriane Siméoni

Chercheur Oriane Siméoni -

Chercheur Tuan-Hung Vu

Chercheur Tuan-Hung Vu -

Chercheur Eloi Zablocki

Chercheur Eloi Zablocki -

Doctorant Léon Zheng

Doctorant Léon Zheng

Doctorant

Machine Learning | Frugal Learning

X | MVA | ENS Lyon

Actualités

Valeo.ai à ICCV’21

En octobre 2021, Valeo.ai participe à ICCV, une des plus importantes conférences de vision artificielle, y présentant six articles sur l’analyse de scènes complexes à l’aide d’une caméra, d’un radar ou d’un lidar.

Valeo.ai x CVPR’21

En juin 2021, Valeo.ai participe à CVPR, la plus importante conférence de vision artificielle, y présentant trois articles, contribuant au tutoriel sur le “self-supervised learning”, co-organisant le workshop “Omnidirectional Computer Vision” et délivrant des adresses aux workshops SafeAI4AutonomouDriving et Vision4AllSeasons.

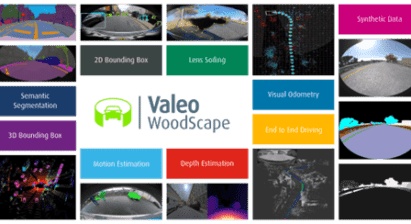

Base de données Woodscape

Quatre équipes de Valeo propose Woodscape, la première base publique de données multi-capteurs de conduite incluant des caméras grand-angle, baptisée en hommage à Robert Wood — qui inventa ce type de caméra à 1906 — et proposant 9 tâches de perception telles que la détection 2D et 3D d’objets,la segmentation sémantique et l’estimation de profondeurs.

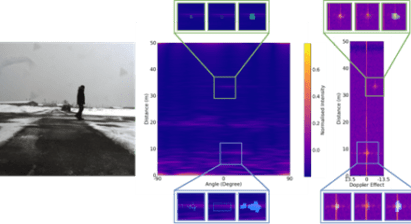

Base de données Carrada

En collaboration avec Télécom Paris, Valeo.ai publie la base de données Carrada (“Camera and Automotive Radar with Range-Angle-Doppler Annotations”), la première base de données radar automobile avec voitures, piétons et cyclistes précisément annotés au niveau du signal brut.

Peut-on interpréter un système de conduite autonome ?

Des chercheurs de Valeo.ai publient une étude complète sur l’explicabilité des systèmes de conduite autonome à base de vision artificielle ; ils y présentent un large panorama de techniques existantes pour l’interprétabilité post-hoc ou par design, en analysent les limitations et proposent différentes pistes de recherche pour l’amélioration de l’interprétation des futurs systèmes de conduite autonome.

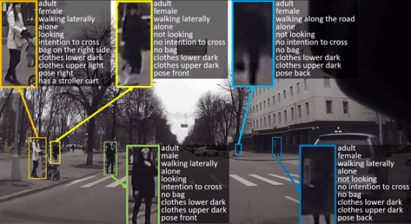

Faire attention aux usagers vulnérables de la route

Les usagers vulnérables de la route tels que les piétons doivent être particulièrement bien analysés pas les systèmes de conduite assistée ou automatisée ; Valeo.ai montre que l’insertion de piétons synthétiques dans des scènes réelles permet d’entraîner de meilleurs détecteurs (en collaboration avec CTU Prague) et qu’un modèle multi-tâches permet de reconnaître jusqu’à 32 attributs dont l’intention et l’attention des piétons (en collaboration with l’EPFL).